Veranstaltungsbericht: Datensammlung und Diskriminierung

###Rassistische und sexistische Algorithmen bereits im Einsatz

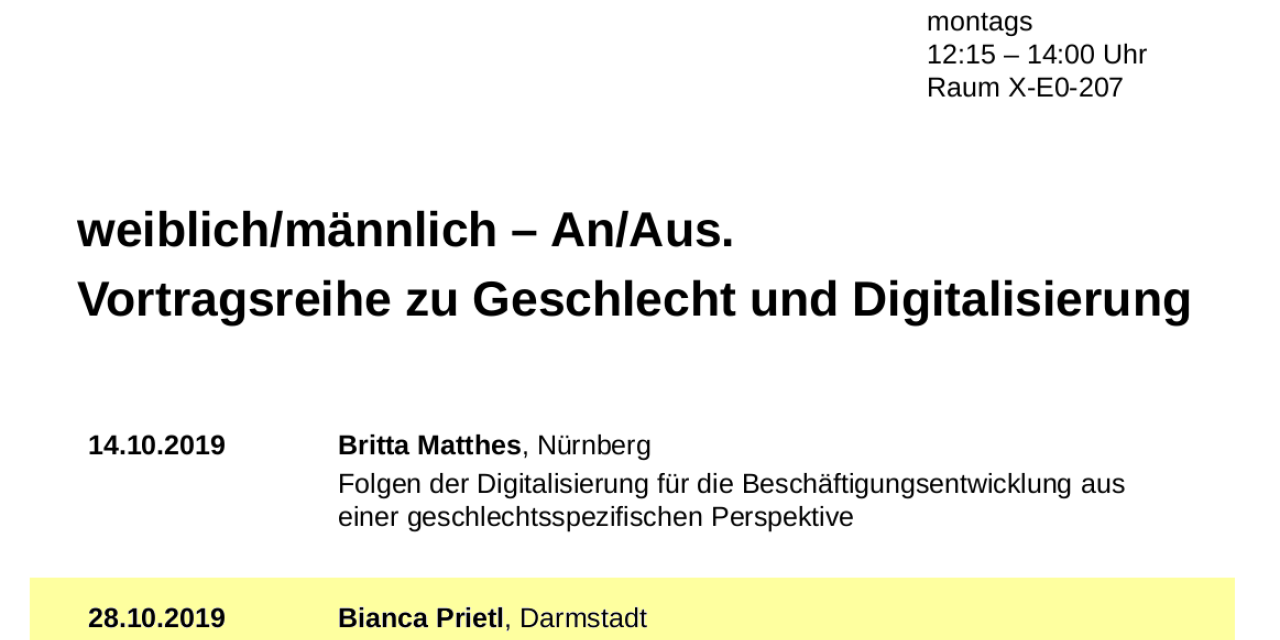

Bianca Prietl, promovierte Soziologin der TU Darmstadt, erläuterterte wie Digitalisierung gesellschaftliche Verhältnisse beeinflusst. Wichtige Instrumente seien dabei Algorithmische Entscheidungssysteme, die mit mehr Effizienz, Neutralität und geringen Kosten beworben werden. Das ist ein faules Versprechen, denn diese Entscheidungssysteme zementieren Diskriminierungsstrukturen. Als Beispiel führte sie einen Algorithmus aus den USA an, der angewendet wurde, um das Rückfallrisiko von Kriminellen einzuschätzen – mit dem Ergebnis, dass Schwarze Menschen strukturell als gefährdeter galten. Auch in Österreich finden solche Programme Anklang: Das österreichische Arbeitsamt (AMS) verwendet einen Algorithmus, der die Wiedereingliederungsmöglichkeit von Arbeitssuchenden bewertet. Hierbei werden Frauen (insbesondere Mütter) und Menschen über 50 Jahre als schwer vermittelbar diskriminiert.

###Wissen als vermeintlich objektiv

Feministische (Technik-)Forschung betont, dass Wissen nicht objektiv ist, sondern im Kontext der Entstehung verstanden werden muss (siehe dazu auch „Androzentrismus im Netz – Androzentrismus in den Wissenschaften“. Im technischen Bereich finden sich daher patriarchale, kapitalistische und postkoloniale Herrschaftsstrukturen wider.

Das Problem bei Algorithmen, die selbstständig Entscheidungen treffen, sieht Prietl darin, dass sie darauf ausgelegt sind, Muster in Datensätzen als Wahrheiten anzuerkennen. Diese Muster unterschlagen jedoch Diskriminierungsstrukturen und dadurch beispielsweise die Kausalität von Frauen, Mutterschaft und längeren Fehlzeiten in der Arbeitswelt. Wenn ein Algorithmus daraus den Schluss zieht, dass Frauen schwieriger in die Arbeitswelt zu integrieren sind, bedeutet dies eine Reproduktion von sozialer Ungleichheit. Dabei geht es nicht nur um die Diskriminierung aufgrund des Geschlechts, sondern auch aufgrund von Herkunft, Klasse etc. Schwierig dabei ist: diese Algorithmen verstehen das, was ist, als einzig Wahres und Mögliches. In dieser Logik bleibt kein Raum für Veränderung - weg von Diskriminierungen und hin zu einer gerechteren digitalen Gesellschaft.

###Private Datenmonopolisten zementieren Privilegien

Prietl problematisierte außerdem die Privatisierung von Wissensproduktion durch Anbieter wie Alibaba, vor allem aber auch Großkonzerne wie Google.

Zunehmend arbeiten diese mit staatlichen Organisationen wie Geheimdiensten zusammen.

Der maschinellen Auswertung von Daten müssten klare Grenzen gesetzt werden, beispielsweise nach den Leitlinien, die kürzlich von der Datenethik-Kommission veröffentlich wurden.

Abschließend wurde darauf verwiesen, dass gerade die Bereiche, die im Zuge von Datensammlung wichtig sind, überwiegend von mehrfach privilegierten Menschen dominiert werden: von gebildeten, weißen Männern. Dadurch feiert das Ideal des männlichen und weißen Erkenntnisträgers ein Revival. Dabei verbirgt es sich hinter vermeintlich objektiven Algorithmen.

Zum Ende des Vortrags bleiben zwei Forderungen: einerseits die Entwicklung fairer Algorithmen, die Ungleichheitsstrukturen entgegenwirken statt sie zu zementieren und andererseits umfassender Datenschutz für eine big-data Gesellschaft.

Unterstützen Sie die gute Sache: Freiheit, Grundrechte und Demokratie.

Viele Menschen engagieren sich bei uns in ihrer Freizeit, seien auch Sie dabei!

Bleiben Sie auf dem Laufenden über unsere Arbeit und unsere Themen.

Unsere Arbeit lebt von Ihrer Unterstützung

Wir freuen uns über Spenden und neue Mitglieder.